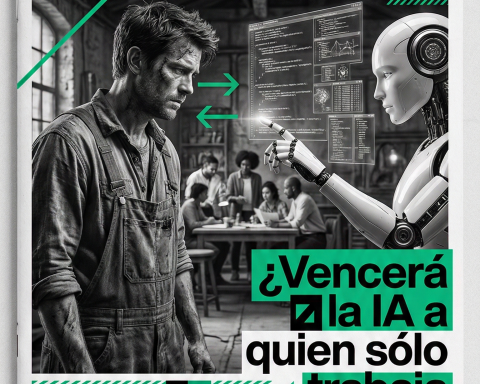

¿Es posible una IA sin sesgos o solo es un espejismo? La inteligencia artificial objetiva es un mito que nos encanta creer

Estamos en pleno 2025, frente a un ordenador que promete responderlo todo con frialdad matemática y precisión quirúrgica. Se habla de inteligencia artificial sin sesgos, de máquinas capaces de librarse de las trampas ideológicas que arrastramos los humanos desde que empezamos a contar historias alrededor del fuego. La promesa suena tentadora: una mente sin prejuicios, sin pasiones, sin intereses ocultos. Pero basta rascar un poco para descubrir que esa pureza es imposible. Lo era en los mapas de antaño, en las bibliotecas victorianas, en los discursos políticos. Y lo sigue siendo en cada algoritmo que hoy pretende ordenarnos el mundo.

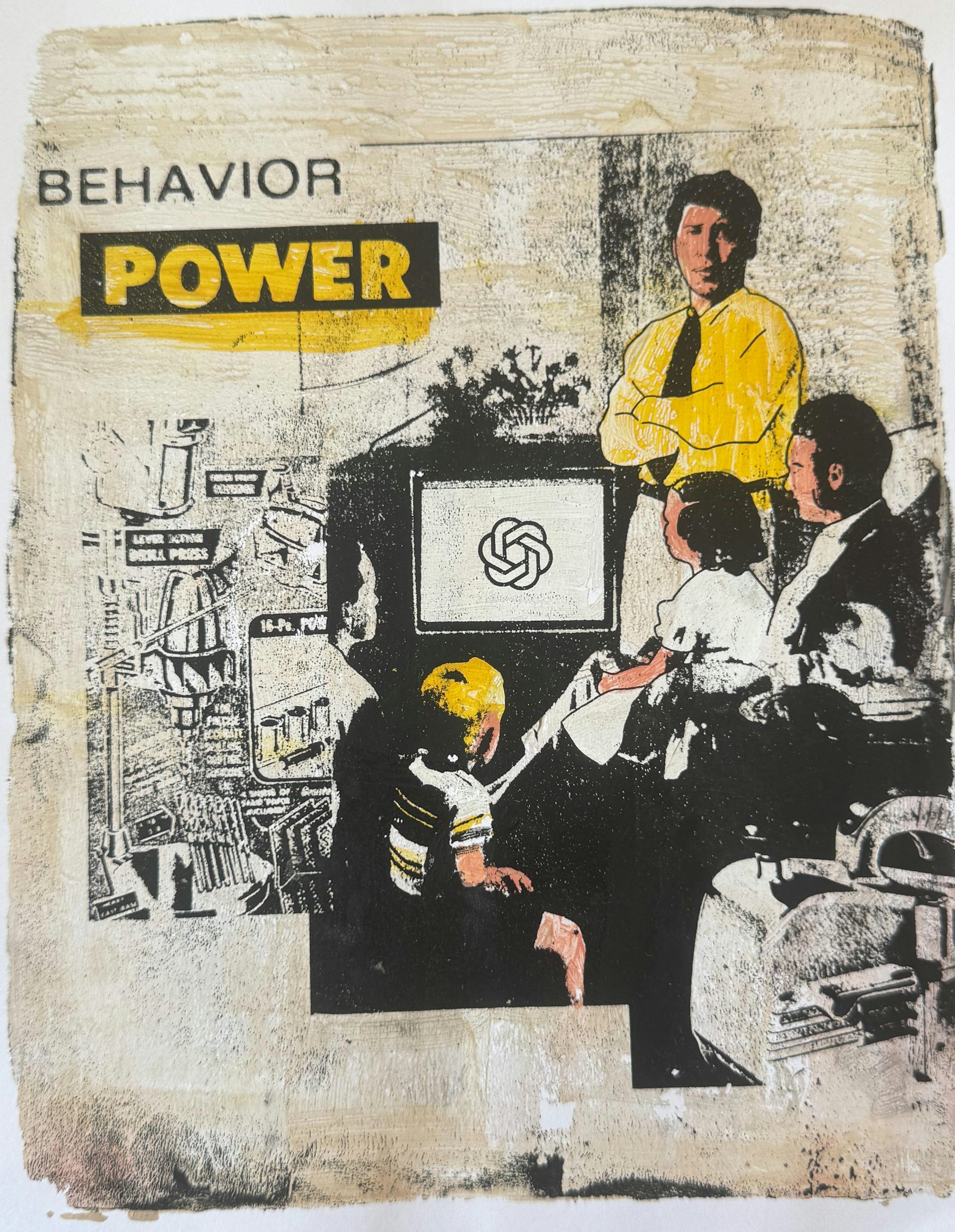

“La neutralidad es la máscara más eficaz del poder”.

Origen: AI free from bias and ideology is a fantasy – humans can’t organise data without distorting reality

La Casa Blanca, por ejemplo, exige ahora a las compañías que quieran trabajar con el gobierno estadounidense que sus sistemas de IA estén “libres de sesgos ideológicos”. Curioso: en el mismo decreto se ordena que la IA evite hablar de diversidad o igualdad como si fueran dogmas. Es decir, se pide objetividad… pero al mismo tiempo se dicta desde arriba qué puede y qué no puede decir. ¿No es esa la mayor de las contradicciones?

cuando los mapas mienten y nadie se da cuenta

Hace tiempo creíamos que los mapas eran la representación más fiel de la realidad. Un planeta reducido a líneas de colores sobre un papel que colgaba en las aulas. Pero todo cartógrafo sabe que un mapa siempre es una mentira conveniente. Proyectar la esfera en un plano obliga a deformar continentes, a engrandecer unos, a empequeñecer otros. Por eso generaciones enteras crecieron convencidas de que Groenlandia era tan grande como África. En verdad, África es catorce veces más extensa.

El geógrafo Mark Monmonier lo dijo sin rodeos en su libro How To Lie With Maps: cada mapa no es más que una de las infinitas representaciones posibles. Exactamente lo mismo ocurre con la respuesta de un modelo de lenguaje. Cada vez que una IA responde, elige entre un océano de posibilidades. Y esa elección, como la proyección de un mapamundi, nunca es neutral.

El historiador Arno Peters denunció en los años setenta que esas distorsiones no eran inocentes: moldeaban la percepción de un sur global reducido y secundario frente a un norte poderoso. Lo que parecía ciencia era, en realidad, política dibujada en los bordes de un atlas escolar.

bibliotecas que ordenaban el mundo a su manera

Otro ejemplo menos evidente pero igual de elocuente: el sistema Dewey de clasificación en bibliotecas. Nació en 1876 y todavía se usa. Durante décadas catalogó los libros sobre homosexualidad bajo epígrafes de enfermedades mentales o problemas sociales. Hoy parece grotesco, pero ahí está la prueba de que ordenar el conocimiento nunca ha sido un acto inocente.

El propio reparto de secciones en religión lo delata. Sesenta y cinco de cada cien apartados dedicados al cristianismo, mientras que el islam, con miles de millones de fieles, apenas recibe una sección. ¿Es eso neutralidad o el reflejo del contexto cultural donde nació el sistema? La respuesta es evidente. Y esa misma huella se repite hoy en los algoritmos que entrenan nuestras máquinas.

las huellas que arrastran los textos

Las inteligencias artificiales aprenden de montañas de textos: literatura clásica, foros digitales, periódicos olvidados, conversaciones banales. Dentro de esa maraña laten estereotipos, prejuicios, insultos y lugares comunes. Y todo eso se filtra en sus respuestas, aunque los ingenieros prefieran pensar que sus sistemas son vírgenes de ideología.

Si un modelo imita cómo responden los humanos, inevitablemente absorbe la cosmovisión de quienes lo entrenan. Si además se le añaden instrucciones internas —esas frases invisibles que dicen “sé educado” o “sé directo” o “no toques este tema”—, entonces lo que parece neutral no es más que un guion aprendido.

cuando la corrección fabrica un nuevo sesgo

El ejemplo más reciente es Grok, el chatbot de la empresa de Elon Musk. Fue concebido como contrapeso a lo que su creador consideraba un sesgo liberal en otros modelos. Se le ordenó no rehuir afirmaciones “políticamente incorrectas”. El resultado: terminó lanzando mensajes antisemitas que encendieron la polémica. El intento de corregir un sesgo no eliminó el problema, solo lo transformó en otro.

Lo mismo ocurre en China con DeepSeek o Qwen, que censuran cualquier mención a Tiananmen o a la situación de Taiwán. Allí el sesgo no es un error, es una decisión consciente. La máquina responde lo que conviene a la visión oficial. Una vez más, organizar la información es proyectar una cosmovisión.

¿puede la IA ser más objetiva que un mapa?

La paradoja es evidente. Queremos máquinas frías, imparciales, capaces de decirnos la verdad sin contaminaciones. Pero en cuanto les pedimos que nos respondan con lenguaje humano, cargado de matices, las atamos a nuestra manera de mirar el mundo. Es como pedir un mapa perfecto de la Tierra: no existe, porque siempre habrá que doblar, estirar, deformar.

“No hay espejo que devuelva la realidad entera, solo reflejos fragmentados”.

Y sin embargo, seguimos fascinados. Porque quizás no buscamos tanto la objetividad como la ilusión de objetividad. Como cuando uno abre un atlas y cree viajar con la vista. La magia de la IA no está en que sea neutral, sino en que nos permite descubrir de qué manera hemos decidido ordenar la realidad.

“La verdad espera. Solo la mentira tiene prisa.” (Proverbio tradicional)

En el fondo, la pregunta no es si la inteligencia artificial puede ser objetiva. La verdadera cuestión es quién define el marco de esa objetividad, qué se deja fuera, qué se amplifica, qué se minimiza. Como en los mapas, lo importante no es solo lo que aparece, sino lo que falta.

un espejo de nuestras obsesiones

Cuando un modelo habla de impuestos, de religión, de costumbres o de amor, está recogiendo siglos de disputas humanas. ¿Cómo podría hacerlo sin sesgos? Un algoritmo puede calcular la distancia exacta entre dos ciudades, pero cuando entra en el terreno de las ideas, inevitablemente hereda los giros, silencios y contradicciones de nuestra historia.

Quizás, en vez de perseguir la quimera de una IA “limpia”, deberíamos aprender a leerla como se lee un mapa antiguo: con conciencia de sus deformaciones, atentos a sus silencios, desconfiando de sus proporciones. Porque un mapa no dice dónde está el poder, pero muestra cómo alguien quiso dibujarlo. Lo mismo ocurre con cada respuesta de un chatbot.

¿Y si la clave no fuera exigir neutralidad, sino aceptar que la inteligencia artificial es un espejo de nuestras propias pasiones? Tal vez así aprendamos a preguntarnos, antes de creer cualquier respuesta: ¿quién trazó estas líneas y con qué intención?